Es ist aber auch verführerisch. Plötzlich liegt da so etwas wie ein Zauberstab auf dem Silbertablett. ChatGPT heißt das Wunder aus dem Web. Künstliche Intelligenz ist seine Lebensquelle. Fürs Lernen, Lehren und Korrigieren ist all das eine riesige Herausforderung. Prof. Dr. Michael Marré vom Fachbereich Maschinenbau der Fachhochschule Südwestfalen in Iserlohn lässt die Studierenden ausprobieren. Und setzt auf den Lerneffekt.

Chance oder Gefahr?

Verbieten oder verwenden? Überall, wo Prüfungen anstehen, sind ChatGPT und andere Bots schon da. Das gilt natürlich auch für die Fachhochschule Südwestfalen in Iserlohn. Prof. Dr. Michael Marré lehrt dort am Fachbereich Maschinenbau. Vom Verbieten hält er wenig. Er möchte, dass die Studierenden selber lernen, was KI kann. Und was nicht. In einem Seminar ließ er sie die Themen ihrer Arbeiten doppelt recherchieren. Einmal mit Hilfe von Chatbots und einmal auf die klassische Weise. Mit Literatur.

Künstliche Intelligenz vs. Literatur

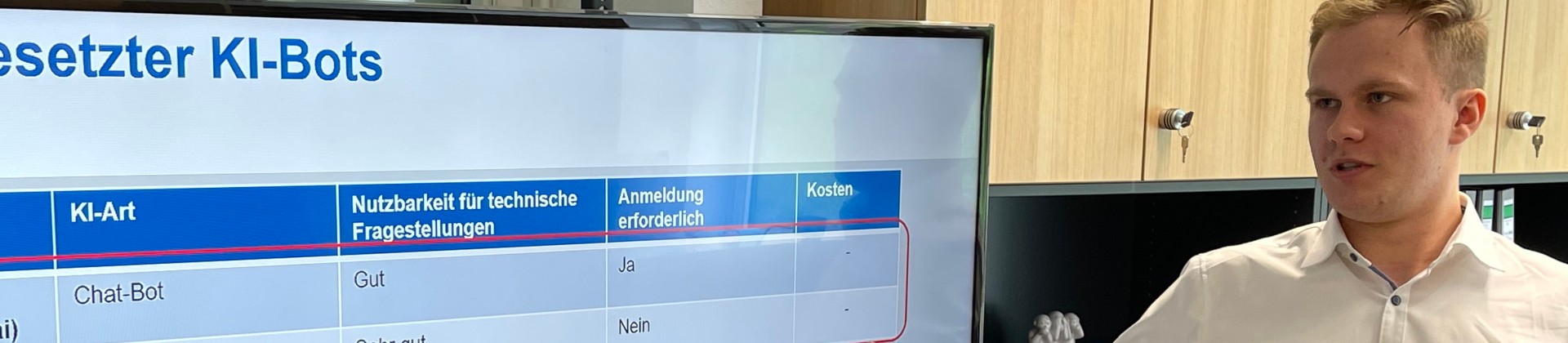

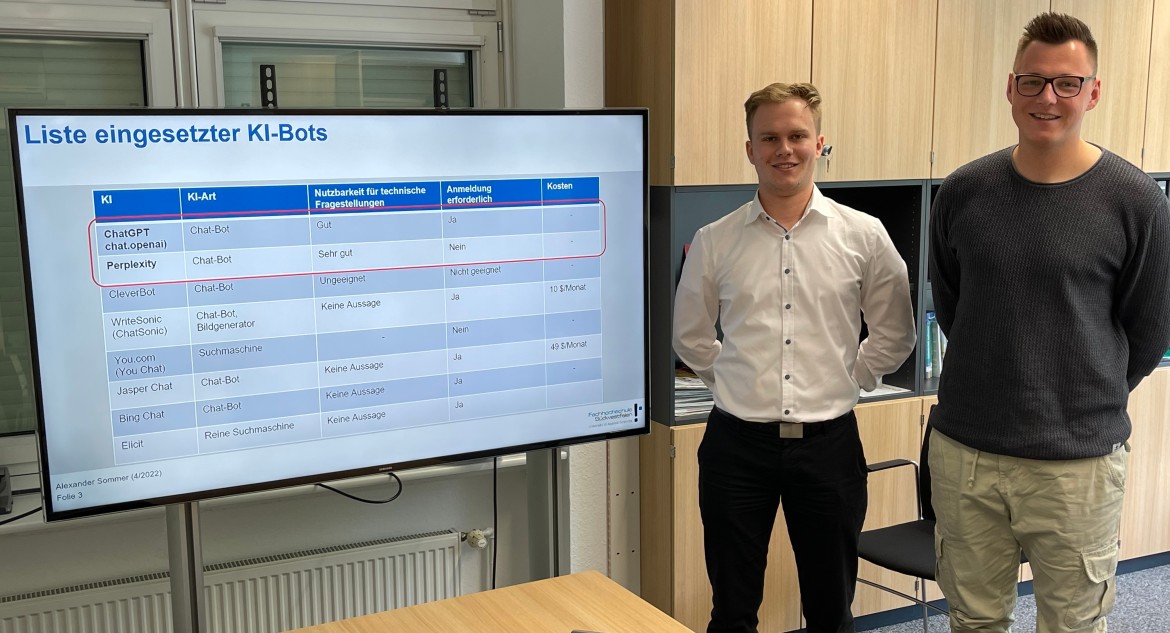

Alexander Sommer und Marvin Leding bekamen von Michael Marré genau diesen Sonderauftrag. Für ihre schriftlichen Abschlussarbeiten im Seminar Digitale Transformation in der Fügetechnik durften, nein mussten sie den Pakt mit der Künstlichen Intelligenz eingehen. Ihr erster Eindruck: „Wahnsinn“, sagt Alexander Sommer, „innerhalb von ein paar Sekunden bekommt man einen zusammenhängenden Text. Ein Unikat.“ „Und der liest sich echt super“, ergänzt Marvin Leding. Die beiden Fertigungstechnik-Studenten testeten natürlich nicht nur ChatGPT, sondern bis zu 15 weitere Bots. Jeder hat nämlich andere Stärken. „ChatGPT liefert keine Quellen, Perplexity zum Beispiel schon“, erläutert Alexander Sommer. Generell arbeiten aber alle Bots nach dem gleichen Prinzip. Nach Wahrscheinlichkeit. „Sie spucken aus, was der Fragensteller wahrscheinlich wissen will“, erklärt Marvin Leding.

Bots: Im Detail unscharf

Und genau da liegt ein großes Problem. Die KI-Antworten sind wahrscheinlich richtig. Vielleicht aber auch nicht. „Und je komplexer die Fragestellung ist, desto wahrscheinlicher ist die Antwort nicht vollständig korrekt“, sagt Alexander Sommer. In seiner Arbeit hielt er die Literatur-Recherche dagegen und konnte die Künstliche Intelligenz damit vielfach überführen. „Im Großen und Ganzen passte das schon“, so sein Urteil, „aber im Detail sind die Bots unscharf oder liegen daneben. In der Fertigungstechnik reicht das nicht.“